Revista Controle & Instrumentação – Edição nº 238 – 2018 |

|||

| ¤

Cover Page

|

|||

|

|||

| Oque separa uma planta que opera razoavelmente

bem de outra que atinge um alto nível

de excelência? Muito provavelmente, é a capacidade

de usar os dados de diagnósticos de forma eficaz,

dando transparência à planta – possibilitando a visualização

de como cada parte está funcionando, em tempo

real. Para que cada parte funcione da maneira ideal,

as malhas de controle que as suportam devem trabalhar

como projetado, o que depende dos instrumentos operarem

de maneira confiável para fornecer dados precisos. Instrumentos inteligentes são capazes de monitorar seu próprio desempenho, e podem dizer muito sobre o que está acontecendo com um processo. Mas, quem os está monitorando? A tomada de decisões de forma mais rápida e inteligente depende do acesso a dados precisos. Existem duas verdades sobre os dados: todo mundo quer ter acesso a eles para saber o que está acontecendo na planta em tempo real e os dados carregam imprecisão. |

|||

|

|||

| Os engenheiros de controle

estão usando inúmeras ferramentas para garantir que seus

dados sejam precisos. Com os avanços na instrumentação,

o aumento na capacidade de armazenamento e a

melhoria no desempenho dos meios computacionais, às

vezes, milhares de variáveis são simultaneamente medidas

e registradas e, então, esses dados podem ser disponibilizados

e acessados. Isso deu poderosas ferramentas para

o monitoramento contínuo em tempo real do comportamento

do processo para desenvolvimento de modelos

mais robustos e para fins de otimização e controle. Mas,

como os dados são obtidos através de instrumentos físicos

e rotinas de medição, que apresentam precisão finita,

naturalmente possuem erros, são inerentemente inconsistentes,

seja por erro do instrumento ou por flutuação do

processo. No entanto, as empresas usam dados de fábrica

para suporte, manutenção, planejamento e otimização

de operações. Eles também enviam esses dados para o

sistema de planejamento de recursos empresariais (ERP).

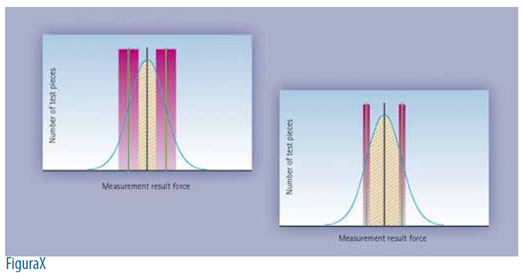

Então, a precisão é crítica; dados defeituosos podem resultar

em problemas de anomalias, incluindo decisões

operacionais inseguras ou insatisfatórias. As medições dos processos estão sujeitas à incidência de erros durante as etapas de medição, processamento e transmissão do sinal erro total em uma medição, que é a diferença entre o valor medido e o valor real da variável e podem ser representadas pela soma da contribuição de dois tipos de erro – aleatórios e sistemáticos. O erro aleatório não possui características de poder ser predito com acurácia: um mesmo experimento, sob as mesmas circunstâncias pode ter resultados diferentes, dependendo do erro aleatório; ele é melhor caracterizado com o uso de distribuição de probabilidade. E esses erros podem ser causados por diversas fontes e, ainda que não possam ser totalmente eliminados numa medição, correspondem a um componente de alta frequência e baixa magnitude, exceto pelos picos esporádicos de ocorrência. |

|||

|

|||

|

|||

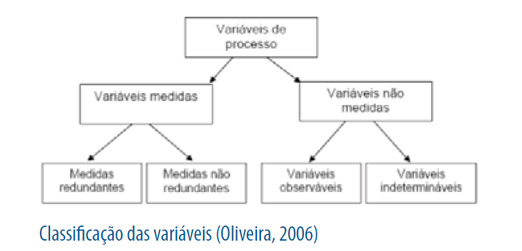

| Já os erros sistemáticos são causados por eventos não

aleatórios, como mau funcionamento do instrumento,

falta de calibração, falha na comunicação, sensores desgastados,

etc. Mas a não aleatoriedade desse erro implica

que, se a medição for repetida sob as mesmas circunstâncias,

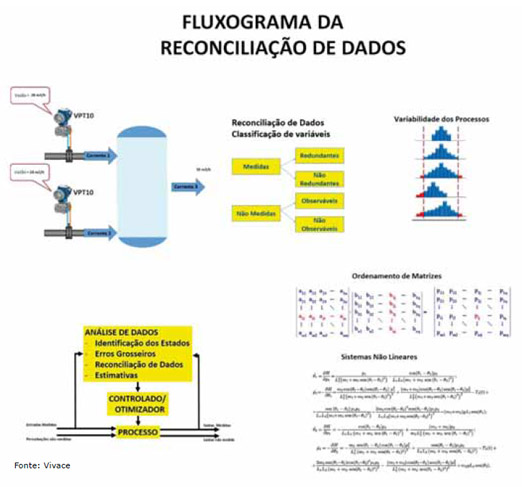

sua contribuição sistemática será a mesma. Os erros sistemáticos podem ser evitados ou minimizados com manutenção e calibração adequadas – alguns causadores desses erros aumentam a magnitude do erro durante um longo período. Mas, é possível reduzir os efeitos dos erros aleatórios e eliminar os sistemáticos com a reconciliação de dados, técnica que promove o ajuste das medições de um processo, de modo a alcançar um conjunto de dados consistentes com o balanço material e de energia. Dos dados reconciliados, espera-se maior acurácia. Mas, para que as técnicas utilizadas sejam efetivas, não deve haver erros sistemáticos – e existem técnicas para detectá-los. As técnicas exploram a redundância de medições para alcançar a redução dos erros. Técnicas de processamento de sinais e reconciliação de dados podem ser aplicadas em conjunto, recebendo o nome de condicionamento de dados. Para sistemas que tenham variáveis medidas e não medidas, a melhor forma de abordar o assunto é com a decomposição da reconciliação: reconciliação de variáveis medidas com redundância e variáveis não medidas. A reconciliação de dados permite obter uma maior eficiência no desempenho das malhas, já que seu objetivo é efetuar estimações mais precisas de determinadas medições, relacionadas ao modelo do processo – dado por um conjunto de equações algébrico-diferenciais, que podem representar as leis de conservação de massa, conservação de energia ou qualquer outra função que relaciona as variáveis medidas com as variáveis do modelo. Utilizam-se as leis de conservação, porque elas são essenciais para a análise dos sistemas e as chances de falharem são muito pequenas, mesmo que ocorram erros em parâmetros do sistema analisado. Uma lei genérica para a quantidade total de massa pode ser descrita como segue. Ela consiste basicamente em uma descrição de fluxos de massa de entrada e saída de um processo, cujo princípio se baseia na lei de conservação de massa, sendo expresso por: Entrada – Saída + Geração – Consumo = Acúmulo. |

|||

|

|||

| A reconciliação de dados possibilita aumento de confiabilidade dos mesmos, já que faz a consistência dos dados em uma frequência que permite a identificação e correção dos erros; reduz perdas nos processos com consequente redução de custos; melhora a performance nas medições, já que permite facilmente a identificação dos instrumentos que estão incertos, descalibrados e causando erros; reduz custos de manutenção, já que permite uma melhor avaliação na manutenção de equipamentos com problemas nas medições com consequente aumento da disponibilidade. | |||

|

|||

| Então, o grande desafio da reconciliação de dados é permitir a reconciliação em tempo real e que possa agregar valor ao processo, tornando a operação mais eficiente, menos custosa e que os erros grosseiros possam ser identificados quase que instantaneamente. Normalmente, reconciliar dados é uma operação de alta complexidade e processamento, tais como soluções de sistemas não lineares, derivadas, técnicas de ordenamento de matrizes, etc. A identificação correta de cada fonte de informação e a garantia de sua consistência trarão qualidade ao processo de reconciliação e é fundamental. | |||

|

|||

| Sistemas informatizados e metodologias de implantação

facilitam a aplicação da reconciliação de dados e

dão potencialidade ao seu uso, ampliando os benefícios

às indústrias. É, de fato, muito comum que os dados de

uma planta não satisfaçam às restrições dos balanços de

massa e energia, devido a inconsistências das medidas

realizadas. A reconciliação de dados é, então, o método

ou algoritmo responsável pelo ajuste das medições de

processo que contêm erros aleatórios, de maneira que as

medições satisfaçam às restrições de balanços de massa

e energia, por meio de uma otimização de um sistema,

linear ou não linear, dependendo das características do

processo. Por esse processo, se deve atribuir maior erro

ao instrumento de maior incerteza”, diz Cassiolato. “Durante o processamento, temos de levar em conta as perdas, que são chamadas de erros grosseiros e erros randômicos: estes são os vazamentos, perdas de produtos que passam despercebidas, e erros devido a medições incorretas e mal funcionamento de equipamentos. A reconciliação de dados, no contexto de processos industriais, pode ser definida como a utilização de um algoritmo complexo e outras ferramentas que buscam satisfazer o balanço de massa e energia de um regime permanente, levando em conta os erros grosseiros, com o objetivo de obter dados confiáveis de controle e indicadores de performance,” lembra Fernanda. |

|||

|

|||

| Balanços de massa com reconciliação e certificação de

dados é um tema que Agremis G. Barbosa e Marco Coghi

– presidente da ISA Campinas – mantêm no

seu radar há algum tempo (veja artigo nesta

edição!). “Perguntamo-nos, a cada momento, se podemos confiar totalmente em nossos instrumentos, se os balanços fecham... As respostas não são triviais e nos levam a outras perguntas. Será que, se fizermos os balanços de massa possíveis em torno dos equipamentos, unidades e no processo inteiro, eles sempre fecharão? Ou colocamos os desbalanços na conta das variáveis que não medimos diretamente?” |

|||

|

|||

|

|||

|

|||

| Existem várias soluções para a imprecisão dos dados, muitos sensores se tornaram inteligentes o suficiente para se policiarem; na maioria dos protocolos, há um ponto em que a qualidade dos dados é conhecida; os sistemas de controle e o MES também podem detectar dados imprecisos por meio de modelos e aplicativos de reconciliação de dados; alguns aplicativos também podem identificar sensores com erro, que precisem ser substituídos ou calibrados. | |||

|

|||

| Filtrar dados por imprecisões não é algo

novo, porém, como mais dados estão sendo

compartilhados com mais interessados,

esse compartilhamento diminui as distâncias,

dentro e fora das plantas, e tem se

tornado acessível para indústrias menores.

A validação periódica de dados, que

pode ser realizada por um terceiro independente

(como um laboratório externo)

ou por um OEM como parte de um contrato de serviço, é essencial para garantir

a integridade dos dados.

O esforço para validar dados

e identificar rapidamente os

desvios dos valores esperados

deve ser apoiado pela comunicação

e colaboração entre departamentos

tradicionalmente

isolados: um dos benefícios

das tecnologias de automação

conectadas é que elas estreitam

os laços entre as equipes

de TI e TO, e entre o corporativo

e o chão-de-fábrica. Para se certificar de que os dados adquiridos e analisados estão corretos é preciso utilizar sensores que sejam provenientes de fabricantes com alta reputação no mercado de medições, e que ofereçam garantia de seus produtos, além de suporte técnico. E os transmissores de medição devem apresentar um certificado de calibração feita em um laboratório credenciado a organizações que reforçam padrões internacionais de competência técnica. “Mais do que instrumentos de alta precisão, os processos e sistemas de análise precisam que os sensores de campo estejam em condições normais de operação e dentro dos limites de precisão, conforme projeto. Diferente de sistemas de controle, onde é possível o uso de servidores dedicados para gestão de ativos, monitoração de desempenho, os valores disponibilizados em nuvem, usados para criação de Big Data, devem ser confiáveis. Para isso, os sensores de campo devem ter, internamente, a capacidade de resolver questões de diagnóstico durante operação e comparação dinâmica da precisão/degradação dos transdutores, em relação à condição de projeto. Se tudo estiver em condições normais, um sinal simples indicará para as camadas superiores de análise que os dados provenientes do sensor são confiáveis e de boa qualidade,” comenta Cassius. |

|||

|

|||

| “Quanto maior o erro de medição, maior a incerteza nos dados de processo. Essa incerteza afeta não somente a qualidade do produto, mas, em muitos casos, a segurança do produto final, principalmente em aplicações críticas como na indústria de alimentos e farmacêutica. Perdas de produto devido a erros grosseiros, como a falta de calibração de instrumentos, podem ocasionar grandes perdas econômicas. Os instrumentos precisam ser robustos e resistirem às demandas de processo, e serem práticos do ponto de vista de manutenção e calibração. É importante ter parceiros que ofereçam diversas ferramentas para calibração em campo e troca de peças sobressalentes, sem a necessidade de executar uma manutenção intensiva e demorada. Sem dúvida, a manutenção preventiva ainda é a melhor solução para evitar problemas e garantir que a precisão do sensor seja confiável”, conta Fernanda. | |||

|

|||

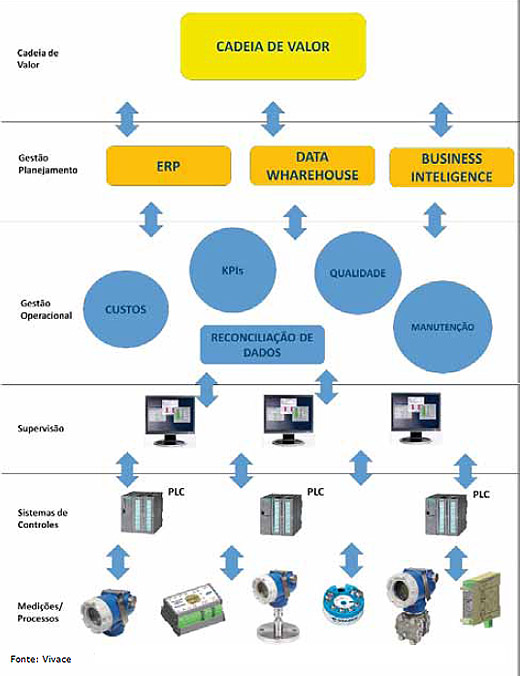

| “Qualquer variável de processo, que possa ser transduzida em grandeza ou valor numérico, pode ser empregada nos modelos de controle e ou geração de KPIs. O desafio na área de instrumentos e sensores está na tecnologia, que garante o desempenho destes dentro dos valores de projeto, garantindo assim a confiabilidade na variável. Tecnologias com “Total Insight” levam à inteligência para dentro dos sensores. Mais do que medir a variável de processo, os sensores têm a capacidade dinâmica de garantir que seu funcionamento está dentro dos limites de projeto. Como uma assinatura dos transdutores, o instrumento consegue analisar a degradação e entregar a previsão de falha ou a expectativa de operação. Essa tecnologia garante, por meio de um simples “flag”, que o instrumento está em condições normais de operação”, afirma Cassius. Straiolo ressalta que dados “defeituosos” podem resultar em decisões operacionais inseguras ou insatisfatórias, e até mesmo acidentes, então, “um ponto muito importante é o aspecto humano, ou seja, quem configura o sistema precisa entender o que está fazendo com relação ao processo, não simplesmente reunir dados e montar malhas de controle. Mas, um sistema que permita disponibilizar os dados dentro do que se propõe a Industria 4.0 também é essencial, uma vez que a quantidade de dados pode confundir os usuários, a entrega dos dados necessários para cada disciplina permite a análise dos dados corretos – sempre levando em consideração a segurança e confiabilidade dos dados, no caminho entre instrumentos de planta e rede corporativa”. “Fica clara a importância que boas informações têm na estratégia de negócios das empresas. Falando na gestão de negócios, lembramos do PIMS e ERPs: os dados de uma planta são normalmente armazenados nos sistemas de gerenciamento de informações de plantas (PIMS) e, aí, são lidos pelos sistemas de reconciliação de dados, produzindo os dados reconciliados, e que são armazenados no próprio PIMS, que fica sendo, assim, a base única de informações da Planta. A integração do chão-de-fábrica com o ERP é feita então, com base nesses dados reconciliados”, lembra Cassiolato. Então, quando a instrumentação existente não fornecer os dados necessários, deve ser hora de atualizá-la! |

|||

| LEIA MAIS NA EDIÇÃO IMPRESSA | |||

| |

|||

| DESEJANDO MAIS INFORMAÇÕES: redacao@editoravalete.com.br | |||

|

|

|