Revista Controle & Instrumentação – Edição nº 237 – 2018 |

|||

| ¤

Cover Page

|

|||

|

|||

| As empresas querem aproveitar ao máximo os dados

que coletam de seus processos. Mas, o que é

importante para uma empresa pode não ser para

outra. Então, determinar as necessidades de cada aplicação

e desafios de produção e do negócio é um começo.

Verificar o que já se tem guardado e analisar os dados

para gerar insights. Dados dos sensores de campo não são

filtrados e raramente são enviados sem tratamento para a

engenharia; dados sobre vibração e temperatura de motores,

por exemplo, ganharam destaque; dados que derivam

das métricas gerais, etc.

Os usuários finais buscam otimizar o que for possível no processo; os fabricantes de máquinas usam os dados para melhorar a performance da máquina ou os serviços de manutenção, indo ao detalhe da operação, e têm utilizado softwares potentes de análise para melhorar suas máquinas em termos mecânicos, eletrônicos e na conectividade com a TI. E cada melhoria possível é implementada para resolver as fraquezas detectadas pelos usuários. |

|||

|

|||

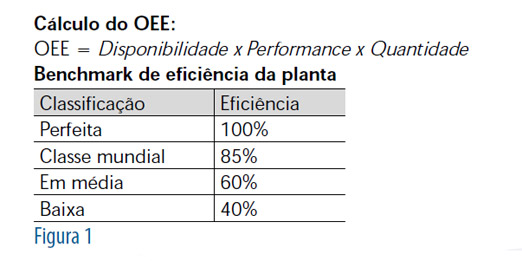

| Segundo Jorge Kawamura, Professor de Engenharia de Produção do Instituto Mauá e um dos coordenadores da demonstração do funcionamento da Indústria 4.0 em diversos eventos, para determinar quais dados devem ser adquiridos é preciso analisar o tipo de processo e o que é necessário medir nele. “Por exemplo, para processos químicos, umidade, temperatura e tempo podem ser variáveis críticas. Uma variável importante em qualquer tipo de processo é o tempo, pois, com ela, é possível extrair vários indicadores secundários, como média de tempo, ocorrências de anomalias em um período, tempo médio entre falhas (MTBF), tempo médio para reparo (MTTR), etc. E um indicador importante para a indústria em geral, gerado pela aquisição de dados, é o OEE – Overall Equipment Effectiveness, ou eficiência global dos equipamentos. Esse indicador mede eficiência da produção da empresa, e seu cálculo e respectivo benchmark de eficiência da planta pode ser visto a seguir (Figura 1). | |||

|

|||

| Para o Professor, a decisão de quais variáveis devem ser coletadas/medidas para o OEE e geração de outros indicadores, a qual fica a critério do responsável pelo gerenciamento da linha de produção, deve ter a cooperação da equipe de TI responsável pelo armazenamento e tratamento de dados, pela implantação de sistemas e infraestrutura computacionais da empresa, e também da equipe de automação que realizará a aquisição dos dados dos equipamentos da linha. Com toda a discussão ao redor da Indústria 4.0, algo que ficou evidente é o fato de que a área industrial, antes, apenas focada em atingir seus índices de produtividade, sem extrapolar os custos operacionais, agora encara uma realidade em que apenas paineis de indicadores afixados próximos às linhas não respondem mais às perguntas, cada vez mais profundas, sobre como cada máquina, processo ou posto estão operando nesse exato momento. E é preciso saber o que acontece em cada ponto da planta. | |||

|

|||

|

|||

|

|||

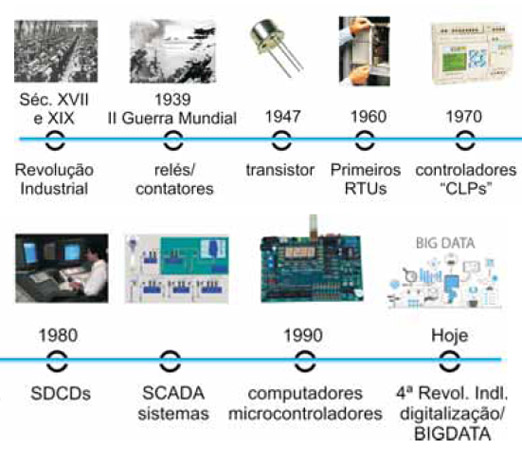

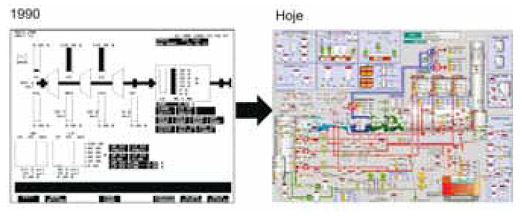

| Cassiolato ressalta a importância de cada passo dos

avanços tecnológicos que culminaram no desenvolvimento

de sistemas de aquisição, controle e automação. Os

primeiros sistemas de automação foram desenvolvidos no

final do século XIX, durante a revolução industrial: o trabalho

que era manual passou a ser realizado por máquinas

dedicadas e customizadas a uma determinada tarefa,

visando, cada vez mais, ao aumento da produtividade e

eficiência. As funções de controle eram implementadas

através de dispositivos mecânicos, que automatizavam

algumas tarefas críticas e repetitivas. Esses dispositivos

eram desenvolvidos para cada tarefa e, devido à natureza

mecânica dos mesmos, tinham

vida útil reduzida e alta manutenção. Mais tarde, com o advento dos relés e contatores, esses dispositivos foram substituídos e apareceram outros, automáticos, em linhas de montagens: a lógica a relés viabilizou o desenvolvimento de funções de controle mais complexas e sofisticadas. Após a II Guerra Mundial, houve um avanço tecnológico, e apareceram as máquinas por comando numérico e os sistemas de controle na indústria de processo, assim como o conceito de referência de tensão para instrumentação analógica. Aparecem os primeiros circuitos integrados, que proporcionaram o desenvolvimento de uma nova geração de sistemas de automação. Cassiolato lembra que, em 1947, Willian Shockley, John Barden e Walter Brattain descobriram o transistor, que é um componente eletrônico amplamente utilizado nos processadores modernos, de forma integrada! No início dos anos 1970, os primeiros computadores comerciais começaram a ser utilizados como controladores em sistemas de automação de grande porte, porém, esses computadores eram grandes, ocupando muito espaço, de alto custo, difíceis de programar e muito sensíveis ao ambiente industrial. Mas, tinham a vantagem de manipular a aquisição e controle de várias variáveis. Ainda na década de 1970, a partir de uma demanda da indústria automobilística norte-americana, foi desenvolvido o Programmable Logic Controller (PLC), ou Controlador Lógico Programável (CLP), um “computador” dedicado e projetado para trabalhar no ambiente industrial, onde sensores e atuadores são conectados a cartões de entradas e saídas. Os primeiros CLPs tinham um conjunto de instruções reduzido; normalmente somente condições lógicas, e não possuíam entradas analógicas, podendo manipular apenas aplicações de controle discreto. Os CLPs foram substituindo os paineis de controle com relés, diminuindo o alto consumo de energia, a difícil manutenção e modificação de comandos e as sempre onerosas alterações de fiação. |

|||

|

|||

| Atualmente, os CLPs manipulam tanto controle discreto quanto malhas analógicas – esses sistemas são chamados de Controladores Programáveis, por não serem limitados a operações com condições lógicas. As atuais funções de controle existentes são distribuídas entre um número de controladores programáveis, montados próximos aos equipamentos a serem controlados. Os diferentes controladores são, normalmente, conectados via rede local a um computador supervisório central, que gerencia os alarmes, receitas e relatórios. | |||

|

|||

| Os anos 1980 trouxeram os SDCDs – Sistemas Digitais

de Controle Distribuídos – e a fase onde a tecnologia

e conectividade industrial eram proprietárias e um “casamento”

entre cliente e fornecedor. Com os avanços

tecnológicos, na década de 1990, os circuitos eletrônicos

passaram a proporcionar maior eficiência, maiores velocidades,

mais funcionalidades, maiores MTBFs – Mean

Time Between Failures, maior confiabilidade, consumos

menores, espaços físicos menores e, ainda, com reduções

de custos. Ao mesmo tempo em que impulsionou o desenvolvimento

de computadores, interfaces e periféricos

mais poderosos, com alta capacidade de processamento

e memória, e, o mais interessante, dando vazão à alta

escala de produção, com custos reduzidos, e o que foi

uma vantagem de forma geral, pois, aumentou a oferta de

microcontroladores, CIs e ASCIs para toda a indústria. “Como se não bastasse essa revolução eletrônica, os sistemas mecânicos também passaram – e vêm passando – por inovações e modificações conceituais, com a incorporação da capacidade de processamento, tornando-os mais rápidos, eficientes e confiáveis, com custos de implementação cada vez menores. Ao longo dos últimos anos, é cada vez mais frequente a utilização de componentes eletrônicos para acionamento e controle de sistemas mecânicos”, pontua Cassiolato. Ferramentas baseadas em Windows trouxeram o desenvolvimento da interface gráfica e a simplicidade da operação se juntou à crescente capacidade de processamento, estabelecendo a união entre os computadores e a instrumentação. Tornou-se comum instrumentos serem embutidos em computadores de aplicação geral, permitindo medidas diversas e manipulações complexas, e, ainda, grandes capacidades de armazenamento em memória ou disco, monitoração inteligente, apresentação gráfica de fácil compreensão e controle dos processos avançados. “Mas, hoje, não é somente a condição de controle que importa. A gestão da informação, a inteligência da instrumentação, a tecnologia verdadeiramente aberta e não proprietária, os benefícios da tecnologia digital são fatores que agregam valores ao usuário. E, no mundo dos negócios, os dados aquisitados vão ser transformados em alguma etapa em indicadores de desempenho, e que são fundamentais para as empresas, em termos de ter uma análise da performance de acordo com os objetivos organizacionais definidos em seu planejamento estratégico. Sem dúvida, com a implantação e recurso da Indústria 4.0, vários indicadores podem ser criados facilmente e monitorá-los e controlá-los são fatores que podem ser um agente catalisador na geração de diferencial em relação aos competidores. O grande desafio é que praticamente tudo pode ser medido e melhorado dentro de uma empresa, e temos de escolher os mais adequados e representativos para o nosso negócio”, frisa Cassiolato. O Professor Kawamura lembra que os dados devem ser analisados pela equipe de gerenciamento da produção, contando com as mais apropriadas, entre as diversas ferramentas MES – Manufacturing Execution System, ERP – Enterprise Resource Planning, ou mesmo softwares dedicados para auxiliar na gestão e/ou geração de indicadores. “E os dados coletados devem ser armazenados por um intervalo de tempo definido pela equipe de gestão junto com o pessoal de TI, pois, dependendo da frequência de aquisição e de seu tipo, isso pode consumir muito espaço nos sistemas de armazenamento de dados. Já os indicadores de produção gerados pela análise de dados devem ser armazenados para criação de um histórico de produção e benchmark, idealmente em um banco de dados único, pois, uma gestão de informação centralizada pode evitar problemas de sincronização de informações e infraestrutura utilizada. No entanto, os níveis de integração das diversas áreas da empresa, com suas respectivas operações, podem fazer com que integração tenha alto grau de complexidade e alto custo – isso normalmente leva algumas empresas a utilizarem bancos de dados segmentados”. Rodrigo conta que o mais difícil para o usuário é decidir quais dados devem ser coletados, analisados e arquivados. “Aqui cabe uma análise criteriosa, dependendo muito de quantos dados estamos coletando e do nível de detalhamento dos relatórios que desejamos obter no futuro. De maneira geral, não é necessário arquivar todos os dados. E a análise deve ser feita por pessoal com profundo conhecimento do processo, em conjunto com um especialista de dados para gerar a informação necessária para tomada de decisão posterior. Esses profissionais devem trabalhar juntos, de maneira a prover um resumo simplificado, que servirá como ferramenta para a gerência da empresa. E a análise deve ser feita em múltiplos níveis, porque o detalhamento com todos os valores pontuais geraria um grande volume. A melhor opção seria ter a primeira fase da análise realizada no dispositivo que coleta os dados e mandar apenas os dados pré-analisados a um nível superior, para que possam ser novamente tratados e mostrados de forma gráfica e amigável. A capacidade computacional para realizar a análise de espectro pode não ser algo factível para um PLC convencional, mas é totalmente possível para um PC industrial”. O executivo da HBM conta que a análise de dados é um ponto interessante, que gera discussões e promove uma mudança significativa em todas a áreas da indústria, tirando várias empresas e profissionais de uma longa zona de conforto e os fazendo incorporar em sua base de conhecimento elementos que não são relacionados a uma única área do saber. “A análise de dados, antes feita apenas por quem comanda um processo ou linha de produção, ou, apenas por profissionais de áreas bem específicas como estatística, agora passa a ser uma tarefa importante e, ao mesmo tempo, complexa, e com tanta informação que, a cada dia, vemos a evolução de ferramentas, técnicas e abordagens para tentar, de um lado, consolidar toda essa informação e desenvolver modelos que tentem predizer como um processo pode ser otimizado; ao mesmo tempo que se tenta transformar elementos que antes não passavam de figurantes passivos do processo (exemplo dos sensores e condicionadores de sinal), para elementos que podem entregar informação e gerar insight sobre partes do processo, de maneira a enriquecer os dados que são entregues aos sistemas e bancos de dados para processamento e geração de conhecimento sobre uma fábrica por exemplo”, detalha André. O que aconteceu foi que o mercado reconheceu que há muitos dados, de muitos sensores, de muitos tipos, para uma única pessoa analisar. Com os recursos de informática disponíveis, se tornou possível, através de machine learning e outras técnicas de análise, buscar correlações pertinentes. Ainda que as inovações tecnológicas para análise não substituam a experiência dos operadores e engenheiros, são aceleradores de soluções, com transparência, para apoiar as decisões. São um passo natural na história dos processos estatísticos e de controle, mais que apenas uma abordagem de ciência de dados. |

|||

|

|||

| “Os bancos de dados segmentados têm sido a escolha

de muitos usuários, depois de analisados a natureza

dos dados e quem irá ter acesso a eles. Por exemplo, um

sistema que lê a qualidade de energia pode ter, em um

banco de dados local, as amplitudes de todas as harmônicas

adquiridas e, num banco de dados na nuvem, apenas

uma informação genérica sobre a qualidade de energia,

essa informação pode ser disponibilizada para um aplicativo

de celular customizado para a empresa”, conta Rodrigo,

da Beckhoff, enquanto o Professor Kawamura ressalta

que não se pode esquecer a manutenção dos sistemas

computacionais, da infraestrutura de TI e a garantia de

disponibilidade das informações pode gerar altos custos

e, por isso, algumas empresas estão migrando parte de

seus bancos de dados segmentados para a nuvem. Rodrigo também acredita que a nuvem oferece inúmeras vantagens, entre elas, a escalabilidade e a sua característica complementar “On Demand”: na nuvem se paga pelo que se consome, e isso ajuda a viabilizar certas aplicações. “É claro que um estudo detalhado deve ser feito, levando- se em consideração variáveis como: custo, confiabilidade, escalabilidade e, até mesmo a confiança dos usuários em colocar dados sensíveis da empresa na nuvem. E muitas aplicações se podem beneficiar de uma arquitetura mista”. Em relação ao banco de dados, o fator primordial é transformar esses dados em informações e conhecimento que deem vantagem na base de um processo estratégico, de controle ou decisório. Dessa forma, evitam-se riscos e se consegue ser mais assertivo e seguro nos planos de ações a serem tomadas pelos setores da empresa. Mas, também é importante analisar o tipo de endereçamento em Sistemas de Aquisição de Dados – os dispositivos responsáveis por manipular os dados utilizam endereços que podem ser de memória ou de registradores, dependendo do tipo de dispositivo usado. Assim, têm-se entrada e saída mapeada em memória (Memory-Mapped IO) e entrada e saída mapeada em espaço de entrada e saída (IO Mapped IO). Um tipo de aquisição de dados muito utilizado e com campo específico de atuação são os Sistemas de Supervisão e Aquisição de Dados, SCADA – Supervisory Control and Data Aquisition –, sistemas que utilizam softwares para monitorar e supervisionar as variáveis e os dispositivos de sistemas de controle, conectados através de drivers específicos. Esses sistemas podem assumir topologia simples, cliente-servidor ou múltiplos servidores-clientes e, ainda, com o advento de sistemas de automação e controle baseados em redes digitais abertas, permitem arquiteturas cliente-servidor OPC – OLE for Process Control. Quando se fala de aquisição de dados, também vem à mente o Data Mining, a prospecção de dados ou mineração de dados, processo de explorar grandes quantidades de dados à procura de padrões consistentes, com regras de associação ou sequências temporais, para detectar relacionamentos sistemáticos entre variáveis, detectando assim novos subconjuntos de dados. |

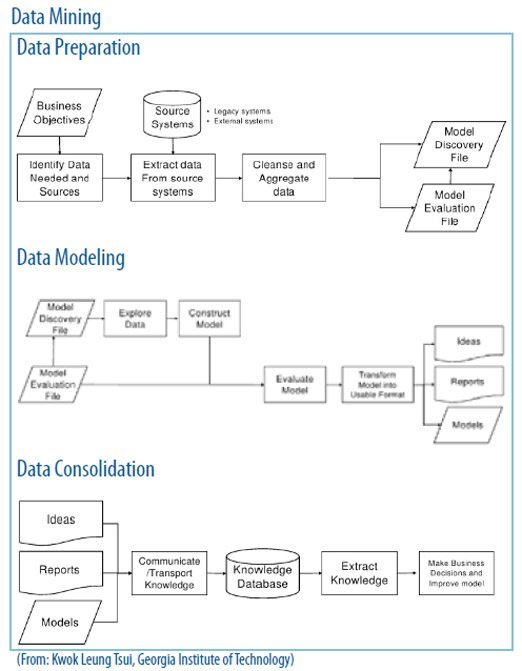

|||

|

|||

| Um tópico recente da ciência da computação que utiliza

várias técnicas da estatística, recuperação de informação,

inteligência artificial, sistemas de aquisição de dados e reconhecimento

de padrões. A mineração de dados é formada

por um conjunto de ferramentas e técnicas que, através do

uso de algoritmos de aprendizagem ou classificação baseados

em redes neurais e estatística, são capazes de explorar

um conjunto de dados, extraindo ou ajudando a evidenciar

padrões nesses dados, e auxiliando na descoberta de conhecimento.

Claro que, para um data mining bem-sucedido, é

necessário um bom banco de dados – e daí nascem repositórios

organizados, Data Marts, Data Warehouses. Cassiolato ressalta que, como os avanços tecnológicos têm sido cada vez mais rápidos, equipamentos e instrumentação já vêm com hardwares poderosos para suportar ferramentas de aquisição de dados que exigem a transferência rápida de dados entre dispositivos, software de processamento e de aplicação com interface gráfica avançada, sensores e controladores de elevada precisão. “Entra-se aí no campo de estudos da nova instrumentação virtual, que, em breve, disponibilizará equipamentos avançados em recursividades, instrumentos virtuais, blocos para a construção da nova geração de instrumentação e medidas. Essas ferramentas devem ser simples e de fácil uso”. O professor Kawamura pede atenção ao fato de que existe diferença na aquisição de dados por protocolo (Hart, FF, Profibus, etc.), por tipo de sistema de controle (SCADA, CLP, DCS, PC) e se o instrumento estiver cabeado ou for wireless. “Apesar de os protocolos seguirem padrões internacionais de comunicação, cada um pode apresentar opções de recursos diferenciados para comunicação entre dispositivos, controladores e atuadores, como, por exemplo, maior alcance de comunicação, maior quantidade de informações a serem transmitidas, leitura de grandezas físicas, entre outras. E cada sistema (SCADA, CLP, PC, DCS) possui funcionalidades específicas. Por exemplo, SCADA e DCS, como sistemas supervisão e aquisição de dados das linhas de produção, enquanto CLPs e a maioria dos PCs Industriais são específicos para controle dos atuadores, leituras dos diversos sensores e pequeno processamento de informações e comunicação de dados. Já a diferença entre cabeados e wireless fica por conta da velocidade de transmissão – principalmente se a transmissão for via fibra óptica. As características positivas do uso de cabos são a velocidade de transmissão e a menor imunidade a interferências magnéticas (cabos ethernet); já as distâncias de conexão entre equipamentos (para cabos ethernet) podem ser menores, os custos para implantação dos cabos (tanto cabos ethernet quanto fibras ópticas) e manutenção também são mais caros. Para uma rede wireless, o baixo custo de implantação, comparado ao sistema cabeado (ethernet e fibra ópticas), maior mobilidade, maior alcance, maior flexibilidade, rápida implantação e menor custo de manutenção são as vantagens; possíveis interferências no sinal por meio de fortes campos magnéticos na mesma frequência e as condições de umidade são desvantagens”. |

|||

|

|||

| SCADA é um acrônimo para Controle de Supervisão

e Aquisição de Dados. Os sistemas SCADA são usados

para monitorar e controlar uma planta ou equipamento,

e esses sistemas foram idealizados para trabalhar

a transferência de dados entre um computador central

e um número de Unidades Terminais Remotas (UTRs)

e/ou Controladores Lógicos Programáveis (PLCs), e terminais

de operação. Esses sistemas podem ser relativamente

simples, como um para monitorar as condições

ambientais de um edifício comercial, ou muito complexos,

como um sistema que monitora uma usina nuclear,

ou um sistema municipal de água. Tradicionalmente, os

sistemas SCADA fizeram uso da rede pública comutada

(PSN) para fins de monitoramento, e a representação

de dados enviada era identificada por endereçamento exclusivo, projetado para correlacionar com o banco de

dados da estação mestre. Atualmente, se pode trabalhar

com vários protocolos diferentes, como a série IEC

60870-5, IEC 60870-5-101, e a versão 3 do Protocolo

de Rede Distribuída (DNP3), por exemplo. Os sistemas

SCADA vêm mudando há muitos anos, adicionando

PCs, novos sensores e data centers, e aumentando a

quantidade de dados que transitam por eles. Todas as mudanças, devido à digitalização de dados e à Internet, também estão transformando o SCADA, que não é mais algo distinto, porque, agora, tudo gira em torno de dados, e o que costumava ser SCADA está convergindo e incorporando muitas novas tecnologias. Virtualização, IIoT, nuvem e análise de dados já fazem parte do SCADA, ou podem ser usados para melhorá-lo ou gerenciá- lo. Isso significa que os usuários mais bem-sucedidos serão aqueles com equipes de TI e TO bem integradas ou departamentos de TI com compreensão significativa de TO, capazes de tornar o SCADA mais um serviço seguro implantado fora da nuvem. Rodrigo Soares frisa que protocolos para adquirir dados com uma alta taxa de amostragem devem ser muito rápidos, como a rede EtherCAT, que garante uma frequência de aquisição alta. “Até o wifi pode ser usado para redes industriais na manufatura, desde que se possa garantir que alguma instabilidade no sinal não cause perda de informações, como rodar um pequeno banco de dados localmente. E é bom lembrar que ambientes classificados são especialmente críticos e exigem cuidados redobrados, uma vez que uma falha em qualquer componente pode causar graves perdas materiais ou humanas. É imprescindível utilizar hardware certificado e tomar muito cuidado com a instalação, de maneira a se ter um isolamento completo entre as áreas; assim, uma falha numa zona não-segura não se propagará para uma zona segura”. O professor Kawamura ressalta que os dados podem ser aquisitados por coletores de dados, como por exemplo, leitor de dados (que podem utilizar códigos como UPC/EAN/JAN, APC-A & UPC-E, EAN-8 & EAN-13, JAN- 8 & JAN-13, ISBN/ISSN, CODE 39, CODABAR, CODE 128 & EAN 128, CODE 93, ITF2.5, Addendum 2.5, MSI/ PLESSY, China Postal Code, CODE 32, INDUSTRIAL 2.5, STD 2.5, DISCRETE 2.5, MATRIX 2.5, CODE 11, RSS 14, RSS LIM, etc), leitor de RFID, leitor de código de barras, ou mesmo coletores ou aplicativos/softwares que utilizam smartphones/sistemas embarcados, respectivamente, desenvolvidos para uso específicos de coleta de dados. O tratamento dos dados coletados deve ser integrado ao sistema da empresa. Essa integração deve ser realizada por meio de transferência de dados do coletor para o sistema – descarregamento dos dados para o banco de dados via aplicativo/software – ou transferência de dados online para o banco de dados (via aplicativo/software). Daí, os dados inseridos no banco de dados podem ser tratados, com o uso de planilhas eletrônicas, ou ferramentas de Business Intelligence, para geração de indicadores e dashboard. |

|||

|

|||

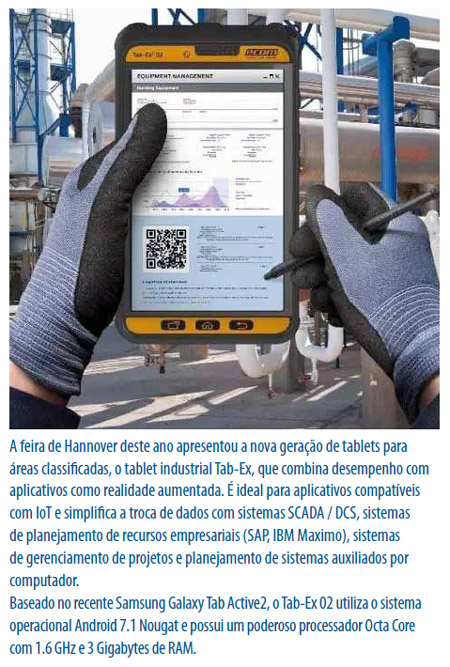

| Toda operação em áreas classificadas deve ter a garantia

de que a área, equipamentos e adequações estejam de

acordo com os requisitos de área e de acordo com as leis

vigentes e classificação de acordo com a NBR IEC 60079.

Dessa forma, é possível certificar se a instalação foi executada

de forma adequada e se os equipamentos estão de acordo

com o tipo de zoneamento – Zona 0, Zona 1 e Zona 2,

referente a produtos inflamáveis, ou Zona 20, Zona 21 e

Zona 22, referentes a poeiras combustíveis, etc. É necessário

especificar equipamentos com tipos e níveis de proteções

específicas para se trabalhar em área classificada. Cassiolato pede atenção aos vários tipos de proteção de equipamentos elétricos e eletrônicos “Ex” certificados: Ex-d, à prova de explosão; Ex-e, segurança aumentada; Ex-p, pressurizado; Ex-i, segurança intrínseca; Ex-n, não acendível; Ex-o, imerso em óleo; Ex-m, encapsulado, Exq, imerso em areia. Por isso, é necessária a especificação correta do equipamento para a área a ser instalada, assim como os níveis de proteção Ga, Gb, Gc, Da, Db e Dc. “Existem muitos casos em que a empresa adquire o equipamento correto, porém, seu uso e/ou instalação é inadequado, colocando a área em condições de risco e em desacordo com as normas. Isso reforça a importância de treinar os profissionais que trabalharão nessas áreas Ex, desde operadores, engenheiros de processos, químicos, mecânicos, técnicos e engenheiros de segurança, capacitando- os em áreas classificadas, de forma a ter conhecimentos gerais dessas áreas, tipos de proteção, níveis de proteção e os riscos envolvidos. E, para dar a devida seriedade a esse processo de treinamento, que envolve capacitação e qualificação dos profissionais, as empresas devem fazer a devida regularização, para a obtenção do certificado das instalações elétricas em áreas classificadas, parte do Prontuário da NR 10, juntamente com o estudo de classificação de áreas”. O Professor destaca que os dados nem sempre vão diretamente do instrumento para os bancos de dados e é preciso dar atenção aos handhelds, smartphones ou tablets, da mesma forma que a desktops ou notebooks. Portanto, realizar backup, atualizar o sistema operacional (quando aplicável) e aplicativos/softwares, instalar antivírus para sistemas mobile (handheld ou smartphone ou tablet), ter cuidado ao acessar ou abrir links de sites e arquivos, limitar o acesso aos dados pessoais e aplicativos continuam válidos para esses sistemas. “Essa atenção deve virar um hábito, pois, já é comum o tratamento de dados durante um procedimento de manutenção com ferramentas analíticas integradas às ferramentas de armazenamento de Big Data, onde os dados não estruturados aquisitados serão armazenados”. “De fato, já começamos a ver alguns exemplos muito interessantes do uso de soluções móveis aliadas a tecnologia de aquisição de dados, realidade aumentada, facilitando a coleta de dados de maneira distribuída, porém extremamente estruturada, permitindo, por exemplo, que um profissional, ao trabalhar na instrumentação de um processo ou linha de produção, possa ao fazê-lo, registrar a localização de um sensor dentro da máquina com o uso da câmera de seu smartphone, ao mesmo tempo que captura um código como um Datamatrix que pode trazer dados de calibração, datasheet e manual com detalhes de conexão com um controlador, condicionador de sinais ou barramento. Uma vez que estes dados são capturados, automaticamente podemos tê-los armazenados em servidores locais (Enterprise Cloud) ou diretamente em serviços de nuvem, com criptografia e de maneira estruturada, linkando todo seu trabalho a uma ordem de serviço ou projeto, tudo armazenado na nuvem”, acrescenta André. “Além de atenção com a apresentação dos dados – pois os usuários desse tipo de aplicativo em geral, não são técnicos – se deve tomar muito cuidado com a segurança da informação. Criptografia e autenticação são prérequisitos mínimos para uma aplicação profissional, grandes corporações não podem ter seus dados expostos ou vulneráveis à interceptação tão facilmente. E é importante estar atento à veracidade da informação porque, mesmo treinados, os técnicos podem interpretar erradamente o comportamento de equipamentos; outras vezes, o usuário simplesmente toma por defeito um comportamento completamente normal, por conta de uma falha de interpretação ou por tentar utilizar um equipamento para uma aplicação diferente daquela para a qual o mesmo foi projetado,” afirma Rodrigo. Para se ter uma produção mais eficiente, flexível, escalável, com redução de recursos e custos e maior qualidade, com confiabilidade, é necessário começar dos sensores que alimentam os bancos de dados via aquisição de dados. A tão celebrada Indústria 4.0 se baseia nisso para ser a conexão lógica de todos os dispositivos e meios relacionados ao ambiente produtivo. A aplicação da computação para automatização de diversos processos industriais tem crescido de forma significativa, com destaque para os sistemas de aquisição de dados e monitoração – lembrando que variáveis, velocidade, volume de dados e infraestrutura diferem um pouco na aquisição de dados para processos contínuos e manufatura. |

|||

|

|||

| “É bom lembrar que quando falamos

em sensores e sistemas de aquisição

de dados inteligentes, existe também

uma parte da indústria que logo

pensa apenas em aplicação de plataformas

de baixíssimo custo (Raspberry

Pi, Arduino, etc.) como alternativa para

se adicionar inteligência distribuída em

processos produtivos. Porém, quando

se fala de aquisição de dados em produção,

a inteligência começa com o uso

de componentes e sistemas que executem seu papel e entreguem

dados com a maior qualidade possível e o mais

importante, entreguem dados que sejam confiáveis. A falta

de exatidão e confiabilidade numa medição utilizada para

medir tolerâncias de um produto ou processo, provoca

aumento de perdas, uma vez que não se pode confiar em

medições feitas por componentes e tecnologias que não

foram realmente pensadas e desenvolvidas para este fim”,

ressalta André Pereira. O que não pode ficar em segundo plano, em nenhum dos casos, é a cybersegurança, com controle de acesso a programas e controle de protocolos de rede, e políticas de segurança devem ser implantadas na empresa – a cartilha do cert.br deve ser o ponto de partida. Usuários vêm colhendo benefícios com sistemas avançados de aquisição de dados e supervisão. Essa mudança deve ser encarada como um processo decorrente dos novos requisitos de qualidade, confiabilidade e segurança do mercado. A sua utilização traz vantagens competitivas, no sentido de que a integração das tecnologias traz aumento de produtividade pela redução das variabilidades dos processos e redução dos tempos de indisponibilidade das malhas de controle. Essa jornada é diferente para cada usuário, dependendo do setor em que trabalha, de suas diferentes exigências e níveis de sofisticação. |

|||

| LEIA MAIS NA EDIÇÃO IMPRESSA | |||

| |

|||

| DESEJANDO MAIS INFORMAÇÕES: redacao@editoravalete.com.br | |||

|

|

|